S’il existe une question récurrente en science économique, pour ne pas dire une énigme, c’est bien celle des gains de productivité : pourquoi traversons- nous de longues phases d’atonie, en dépit de progrès technologiques a priori évidents ? Sommes-nous précisément englués dans l’un de ces régimes de « stagnation séculaire » sans issue apparente ?

Depuis des années, l’automatisation et l’algorithmisation progressent à rythme soutenu, sans effet visible sur la « productivité des facteurs de production » (le terme utilisé par les économistes pour caractériser la valeur ajoutée produite d’une même quantité de travail et d’un même stock de capital). « On peut voir les ordinateurs partout sauf dans les statistiques de productivité », notait déjà Robert Solow en 1987. Comme un écho, la même question se pose près de quarante ans plus tard. Remplacez « ordinateurs » par « intelligence artificielle » et vous obtiendrez même une bonne accroche d’article.

L’évocation de Robert Solow, décédé récemment, mérite bien une pause. L’économiste, récipiendaire du Nobel, n’était pas le plus mal placé pour poser le paradoxe : Solow a bâti sa carrière académique sur la fondation d’une théorie de la croissance reposant en partie sur le progrès technique comme ressort de productivité permettant d’échapper à la loi des rendements décroissants de tout système capitaliste – i.e. l’érosion des gains marginaux observée au fur et à mesure que l’on mobilise des facteurs de production moins efficaces que les tout premiers utilisés.

Pour prendre une image utilisée par Turgot dès le 18ème siècle, la première terre cultivée est a priori la plus fertile, celles qui viennent après seront moins fructueuses. L’innovation technique est là pour remettre du souffle dans la machine de croissance. Autant dire que pour Solow, en 1987, l’absence de matérialisation des gains de productivité consécutifs à la troisième révolution industrielle (l’apparition des ordinateurs dans les entreprises et chez les ménages dans les années 70 et 80) posait dangereusement question.

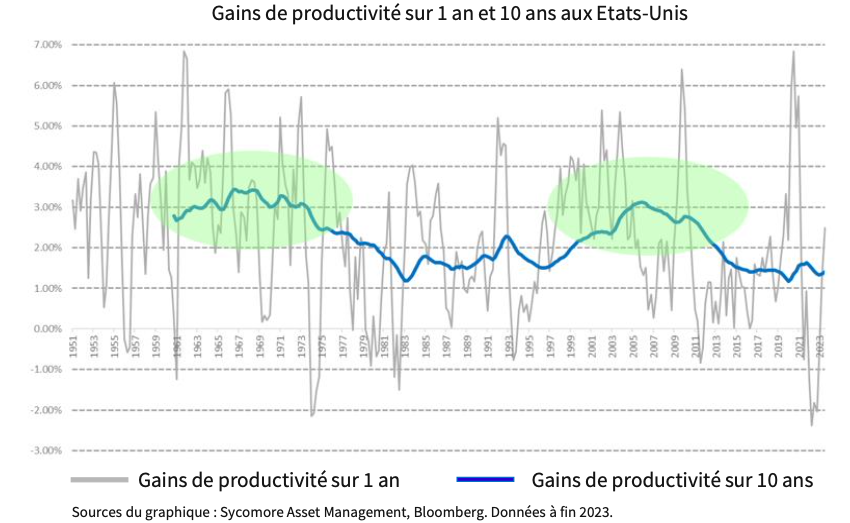

De fait, les statistiques officielles américaines sont parlantes : après l’euphorie des Trente Glorieuses, les gains de productivité sont restés déprimés de la fin des années 70 au milieu des années 90.

D’environ 3,5% de croissance en rythme décennal à un peu plus de 1%. Après l’énoncé de son paradoxe, Solow aura dû attendre encore une dizaine d’années avant de voir les bénéfices de l’informatique se matérialiser dans les chiffres. Une génération plus tard, nous voilà confrontés à la même interrogation. Depuis la crise de 2008, la productivité patine, au point de remettre au goût du jour le concept de « stagnation séculaire », terme apparu lors des peu fastueuses années 30 et repris par Lawrence Summers en 2013 pour décrire ce nouveau régime économique.

Pourquoi les économies développées paraissent-elles incapables de tirer parti des efforts massifs de recherche & développement et de l’adoption pourtant indéniable des outils digitaux ? Pouvons-nous attendre de l’intelligence artificielle, et plus généralement des nouvelles percées technologiques qui nous sont promises, d’ouvrir la voie à un nouvel âge d’or de la productivité ? Précisons sans attendre qu’il ne s’agit pas juste d’un débat pour occuper les experts. Les enjeux sont conséquents. Une étude du McKinsey Global Institute montre par exemple qu’un simple retour des gains de productivité à leur moyenne de long terme (2,2 %) ajouterait 10 000 milliards de dollars sur 10 ans à la création de richesse des Etats-Unis. Le chiffre est commodément rond, mais il a le mérite de situer les ordres de grandeur.

À un moment où la dette de ce même pays se chiffre elle aussi en dizaines de milliers de milliards de dollars... On comprend que le retour à un régime de croissance soutenue des gains de productivité constituerait une porte de sortie (la seule ?) face à l’impasse du service de la dette.

Depuis la crise de 2008, la productivité patine, au point de remettre au goût du jour le concept de « stagnation séculaire », terme apparu lors des fastueuses années 30.

« Nous voulions des voitures volantes »

Si l’on veut savoir si les conditions d’un redémarrage sont réunies ou non, il peut être utile de se demander où sont les freins. À la question « pourquoi si peu de productivité ? », les réponses ne manquent pas.

Une première explication, couramment avancée, tiendrait au fait que les fruits « à portée de main » ont déjà été cueillis. La première partie du 20ème siècle, jusqu’à la fin des années 60, a vu l’émergence et l’adoption massive de technologies profondément transformatrices (l’électricité, le transistor, le moteur à combustion pour n’en citer que quelques-unes) démultipliant la croissance économique. Mais depuis, le progrès technique n’a pas tant que ça changé la donne. Le Boeing 707 inauguré en 1957 se différenciait en quasi tout point du premier avion des frères Wright mais n’est pas si différent du Boeing 777 que vous prenez aujourd’hui (ou pas) pour partir en vacances. L’Homme a marché sur la lune, et après ? Comme le résumait Peter Thiel en 2011, « nous voulions des voitures volantes, à la place nous avons eu 140 caractères », en allusion à X (alors Twitter). Et il faut avouer, le temps passé à « swiper » et « browser » sur les réseaux en tous genres n’est probablement pas le plus économiquement productif.

Plus généralement, les économies occidentales se sont désindustrialisées, faisant la part belle aux services. Mais en la matière, que pouvons-nous attendre ? En caricaturant un peu, quels gains de productivité un masseur ou un Youtubeur peuvent- ils dégager ?

Le passage à une économie de service, notamment sa partie digitalisée, n’est pas non plus sans poser des problèmes de mesure. À ce stade, rappelons que la mesure « officielle » de la productivité passe par celle du PIB. En résumé (grossier), les gains de productivité sont calculés comme étant le résidu de la croissance du PIB que l’on ne peut pas expliquer simplement par le nombre d’heures travaillées (i.e. la croissance démographique et/ou une plus forte participation de la population active) ou par l’accumulation de stock de capital (les équipements et outils de toutes sortes mis à disposition du travail). Problème, comment mesurer l’apport en PIB d’une recherche Google, ou du temps passé sur Internet pour trouver une location de vacances ? Cela vaut aussi et surtout pour les nouveaux produits, ou ceux qui viennent en remplacer d’autres.

Par exemple, la caméra contenue dans votre smartphone a remplacé votre appareil photo, analogique ou digital, détruisant une partie du PIB produit antérieurement par les magasins de photo, les vendeurs de pellicule, etc. Les services digitaux sont un angle mort de la comptabilité nationale. Ceci dit, dans un débat académique qui fait rage, de nombreuses études pointent du doigt l’impuissance des problèmes de mesure comptable à expliquer totalement l’atonie de la productivité, pour plusieurs raisons. L’une d’entre elles tient à l’analyse via des mesures alternatives de richesse, telles que le « Revenu Intérieur Brut » (« Gross Domestic Income »), qui se penche davantage sur les flux monétaires, salaires, dividendes, loyers, intérêts perçus, etc.

Ces revenus croissent plus vite que le PIB, mais pas avec une ampleur suffisante pour expliquer le fossé de productivité, et pas selon des temporalités en ligne avec ce fossé. Un autre contre-argument paraît à première vue implacable : même en prenant les normes comptables en vigueur, quand on se penche de façon plus granulaire, les gains de productivité apparaissent comme en moyenne plus forts dans les secteurs d’activité les plus digitalisés. La finance et l’information sont par exemple deux secteurs significativement plus productifs qu’au début des années 2000 ; quand, à l’opposé, la santé, la construction ou le transport sont à la traîne. Les problèmes de mesure statistique ne peuvent donc à eux seuls rendre compte du phénomène.

Les promesses de l'intelligence artificielle

Non seulement la digitalisation n’est pas un angle mort de la productivité, mais l’accélération récente des progrès de l’intelligence artificielle pourrait marquer le début d’une quatrième révolution « industrielle » (après celles marquées par la vapeur, l’électricité et l’informatique), potentiellement caractérisée par une transformation profonde des modes de production, plus efficaces, plus rapides.

Le développement des « Large Language Models » notamment - ChatGPT pour ne citer que le plus connu - et la démonstration de premiers résultats parfois bluffants sur la génération de textes de façon quasi instantanée font miroiter des gains de productivité. De premières études se sont penchées sur la question, tentant de mesurer l’impact de l’utilisation de l’IA sur des tâches analytiques d’écriture et de création de contenus. Des chercheurs de la Harvard Business School ont ainsi évalué en 2023 que le recours à ChatGPT permettait de produire en moyenne 12,2% plus de tâches, de les réaliser 25,1% plus rapidement, avec une qualité accrue de 40%2. De son côté, une autre étude du MIT estimait le gain de temps à 40% et celui de qualité à 18%3. Des chiffres qui ne sont pas à prendre pour argent comptant, mais qui traduisent bien le sentiment d’un grand nombre d’utilisateurs des algorithmes de génération de textes : bien maniés, ils peuvent grandement accélérer la production de contenus analytiques.

Les premières applications en « vie réelle » sont à portée de main. Début 2024, J.P. Morgan a annoncé avoir développé pour ses clients un outil basé sur l’IA, à même de réduire de 90 % le travail manuel lié à la gestion des « cashflows »4. En outre, si les générateurs de textes ont capté une grande partie de l’attention, le champ d’exploration actuel est bien plus vaste. Dans une suite quasi-logique, il inclut le codage, l’image et la vidéo (amenant dans son sillage une possible disruption des secteurs de la publicité et du cinéma).

Mais plus généralement, l’intelligence artificielle accélère dès aujourd’hui le développement de la recherche dans les sciences de la vie – avec la conception de nouvelles enzymes et protéines, ou de nouvelles façons de lire et d’interpréter le génome – et dans les sciences physiques, par exemple dans le domaine crucial de la fusion nucléaire5. De nouveaux « fruits » à cueillir, moins à portée de main que les premiers, mais pour lesquels l’IA nous ferait la courte- échelle. En traitant très rapidement de vastes quantités de données, avec la capacité d’identifier des motifs récurrents, voire même d’en imaginer de nouveaux, ces nouvelles technologies vont plus vite, et plus en profondeur. Une vraie définition de la productivité.

L'accélération récente des progrès de l'intelligence artificielle pourrait marquer le début d'une quatrième révolution «industrielle ».

Bien sûr, il ne s’agit pas d’imaginer un monde où l’intelligence artificielle prendrait le pas et se diffuserait dans l’ensemble des tâches aujourd’hui confiées à des humains ou à des machines moins performantes. Il arrive que les algorithmes « hallucinent », s’engageant dans des élucubrations illogiques ou irréalistes, sans force de rappel. Il ne viendrait à personne l’idée de confier totalement à une IA les commandes d’un cockpit d’avion rempli de passagers, ou d’un scalpel en salle d’opération. Faute de « remplacement » en masse, on peut au mieux évoquer une symbiose. Mais ces contre-exemples (justifiés) ne suffisent pas à balayer d’un revers de main la possible transformation des modes de production à un horizon qui pourrait bien surprendre.

Laisser le temps au temps

Pour en revenir à Solow, ses attentes ont fini par être comblées, mais après une longue décennie à patienter. Les ordinateurs ont in fine impacté la productivité du travail, de façon indéniable ; leur intégration a simplement pris du temps, plus de temps qu’attendu. L’adoption et l’intégration de nouvelles technologies dans le monde de l’entreprise sont tout sauf des processus instantanés. Il faut modifier les modes d’organisation, les infrastructures de production, les compétences, et parfois même les mentalités. Cette adaptation ne s’opère pas nécessairement à grande vitesse et au même rythme pour toutes les institutions, pour toutes les formes de structuration sociales.

Prenons notre métier : la finance. Il fut un temps où les graphiques boursiers étaient réalisés à la main sur du papier millimétré. L’ordinateur a dû faire progressivement son chemin dans les salles de marché à partir des années 80. Il a fallu lui accorder une confiance minimum pour évaluer des transactions mettant en jeu de vastes sommes d’argent, avec de nouvelles manières de considérer le risque opérationnel. Les opérateurs ont dû apprendre à utiliser ces nouveaux outils, voire à coder directement. Les plus jeunes l’ont adopté plus rapidement que les cohortes les plus expérimentées, parfois réticentes, par intérêt ou conviction. Du papier millimétré au trading haute fréquence (si tant est que ce dernier peut être considéré comme une avancée...), il a fallu changer de millénaire. Quand bien même la preuve est faite que de nouvelles formes de production font gagner en efficacité, leur intégration passe par plusieurs étapes d’acceptation et de transformation. Ces freins institutionnels sont souvent convoqués par les économistes pour expliquer les faibles gains de productivité des dernières décennies.

Une étude récente de Daron Acemoglu, économiste au MIT, note de plus que les premiers exemples d’utilisation d’intelligence artificielle correspondent à des « apprentissages faciles » (« easy to learn tasks »), sans nécessité d’une expertise particulière et aux résultats directement mesurables – par exemple, le temps pris pour rédiger une présentation ou corriger un code informatique.

Selon le chercheur, les choses se compliqueront quand il faudra étendre l’application de l’IA à des tâches « d’apprentissage difficile », pour lesquelles les éléments de contexte sont nombreux et/ou complexes, et pour lesquels des obstacles imprévus peuvent nécessiter un changement de direction. On retrouve une nouvelle fois la distinction entre les fruits à cueillir à portée de main, et ceux, parfois juteux, nichés tout en haut de l’arbre.

L'apport de l'intelligence artificielle pourrait bien cette fois surprendre par sa rapidité.

Cela dit, l’apport de l’intelligence artificielle pourrait bien cette fois surprendre par sa rapidité. Dans le cas des trois précédentes révolutions industrielles, l’intégration des nouvelles technologies a nécessité le renouvellement complet des infrastructures et équipements. Passer du cheval à la vapeur. Passer de la charrue au tracteur. Passer de la clé anglaise au bras articulé. Passer du papier millimétré et du carnet à l’écran et à la feuille Excel. Mais dans le cas de l’intelligence artificielle, le « hardware » existant se prête déjà à peu près naturellement à l’introduction de « softwares » basés sur l’IA. L’assistant « Copilot » de Microsoft, nourri par des « Large Language Models » de type GPT, s’intègre de façon plutôt fluide à l’environnement Windows.

Vous pouvez si vous le souhaitez converser avec un « chatbot » sur votre smartphone, sans avoir à en acheter un nouveau, ni même devoir imaginer un instrument radicalement nouveau pour le télécharger. La transformation est continue, elle ne s’inscrit pas en rupture des précédents modes de production analytique. Certes, il faut changer les microprocesseurs, faisant par exemple la fortune de Nvidia, et la mécanique interne des outils est à revoir. Mais l’infrastructure générale d’un monde nourri d’IA n’a pas à partir d’une page blanche. Attention, dès lors, à ne pas tirer de conclusions hâtives quant au délai que prendront les gains de productivité à se matérialiser.

Du garage à Palo Alto, et retour au garage

À l’heure de s’adapter à cette nouvelle donne, toutes les entreprises ne partent pas sur un pied d’égalité. C’est d’ailleurs l’une des explications parfois avancées pour expliquer la lenteur passée de la diffusion des gains de productivité à l’ensemble de l’économie : l’accaparement de ces gains par une minorité d’acteurs. En l’espèce, si l’on parle de digitalisation et d’intelligence artificielle, les géants de la technologie (les « 7 Magnifiques » constitués de Amazon, Tesla, Meta, Alphabet, Microsoft, Apple et Nvidia) semblent de loin les mieux placés pour tirer les marrons du feu. À l’opposé, les acteurs « traditionnels » seront moins outillés – que ce soit en termes techniques, budgétaires ou humains – pour rivaliser dans cette course de vitesse ; ce d’autant plus que des années de taux quasi nuls et de liquidités abondantes ont maintenu en vie des entreprises « zombies » dont la principale force ne réside vraisemblablement pas dans l’agilité et la capacité à délivrer ces gains de productivité.

La domination des entreprises « superstars » est souvent citée par les chercheurs comme un frein à l’extension du domaine de l’innovation à l’ensemble de l’économie. Mais cette fois encore, méfions-nous des conclusions hâtives. Les toutes petites entreprises ont leur rôle à jouer. En mai 2023, un document interne à Google fuitait sur les réseaux, un « mémo »8 dont les conclusions étaient que le géant de la Silicon Valley, non seulement n’était pas le mieux placé dans la course à l’armement de l’intelligence artificielle, mais que celle-ci serait vraisemblablement gagnée par « l’open source », i.e. la myriade d’acteurs plus ou moins anonymes du domaine engagés dans la co- construction en accès libre de nouveaux algorithmes.

De fait, ce pourrait bien être le retour au garage des pionniers de l’ordinateur personnel, dans un contexte de transformation profonde de l’appareillage technologique de nos sociétés par des entrepreneurs aux moyens bien inférieurs à ceux des mastodontes californiens.

Plus près de nous en France, la « licorne » Mistral AI, dirigée par un ingénieur âgé de 31 ans, va fêter son premier anniversaire et est déjà en mesure de concurrencer des acteurs tels que OpenAI sur le terrain des « chatbots ». Les algorithmes ne sont pas les seuls concernés. On peut aussi regarder du côté des progrès récents de la recherche en matière de production d’énergie, sur le front de la fusion nucléaire par exemple. Le projet de réacteur ITER a été conçu en 2001, la première pierre posée en 2010, et à l’heure où nous écrivons ces lignes, la date de finalisation du chantier a été repoussée à 2030, avec un budget passant de 5 milliards d’euros à 19 milliards aux dernières estimations. Des start-ups se sont depuis lancées dans la course et annoncent des progrès spectaculaires, avec des budgets réduits (500 millions de dollars pour la start-up Hélion, financée en partie par OpenAI), une miniaturisation des réacteurs et de possibles premières livraisons d’énergie aux clients dès 2028.

La surprise de la productivité pourrait donc bien venir de deux côtés : d’une part, l’avancée en apparence inexorable des géants de la technologie, dont l’infrastructure et le pouvoir ne sont pas loin de se mesurer à ceux des Etats, et l’émergence d’un grand nombre d’initiatives de petite taille, mais rapidement mises à disposition des utilisateurs finaux, avec un fort degré de personnalisation et/ou de miniaturisation. En un mot, la surprise pourrait venir de partout.

Contenu rédigé par Tarek Issaoui, Responsable de la Recherche macroéconomique